- Transformer基础

- 常用的大语言模型

- 行业大语言模型

- 大语言模型评估

- 数据构造与清洗

- 分词器构造

- 大语言模型的微调

- 基于PEFT的LLaMA模型微调

- 基于人类反馈的强化学习框架

- 前沿偏好对齐方法

- 基于DPO的偏好对齐实战

- GPTs初体验

- GPTs的初阶使用

- GPTs的高阶使用

- 公开数据集

- 主流方法

- Text2SQL任务实战

- 角色扮演

- 角色扮演实战测试

- 基于Baichuan的角色扮演模型微调

- 对话要素抽取

- 对话要素抽取实战测试

- 基于Qwen的对话要素抽取模型微调

- Agent概述

- Agent的主要模块

- Agent的行为决策机制

- 主流Agent框架

- 基于知识库问答

- 向量数据库

- 基于知识库的大型语言模型问答实战

- AutoGPT概述

- LangChain概述

- 使用LangChain构建AutoGPT

- 运行AutoGPT

下面将介绍如何使用LangChain和AutoGPT实现一个天气报告助手(专业化的代理),这个助手将能够搜索网络,以及读写文件以完成任务。

1)建立项目、设置环境和导入模块。首先创建一个项目文件夹,在项目中创建一个名为app.py的文件,安装相关的Python包,如streamlit、langchain、faiss-cpu、openai等。

接下来在app.py文件中导入所需模块,其中一些重要的包括:SerpAPIWrapper,用于网络搜索;WriteFileTool和ReadFileTool,用于管理文件;faiss和OpenAIEmbeddings,用于语义搜索和理解用户查询。最后是来自LangChain实验模块下的AutoGPT。ChatOpenAI用于我们的聊天模型,此处使用GPT-3.5,这些模块都 来自LangChain框架。代码如下:

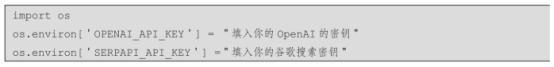

在app.py文件中还要设置API密钥,包括OpenAI的密钥(OPENAI_API_KEY)和谷歌搜索密钥(SERPAPI_API_KEY):

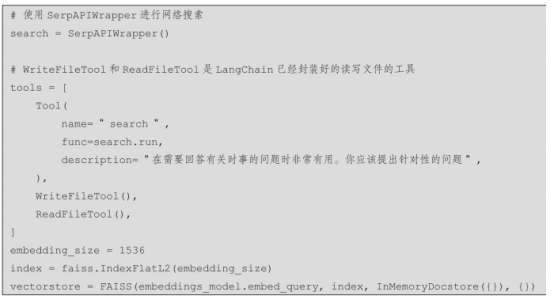

2)设置工具和记忆。AutoGPT代理会配置一些工具和记忆功能。这包括使用SerpAPI-Wrapper进行网络搜索、使用WriteFileTool和ReadFileTool进行文件管理,以及设置使用FAISS和InMemoryDocstore的记忆功能。这些工具和记忆功能将帮助代理理解用户查询的语义意义,并存储相关信息。

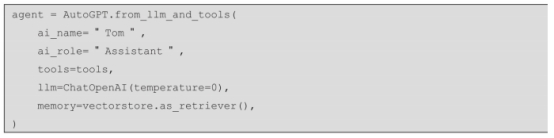

3)实例化LangChain的AutoGPT实现。使用from_llm_and_tools方法创建一个由LangChain实现的AutoGPT代理实例,提供关于代理的详细信息,包括设置的记忆和工具。此外,还使用了LangChain的ChatOpenAI模块,它是OpenAI的ChatModel(如GPT-3.5或GPT-4)的封装。

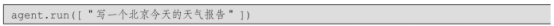

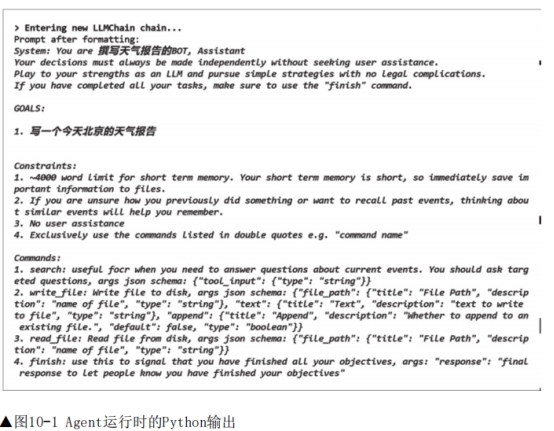

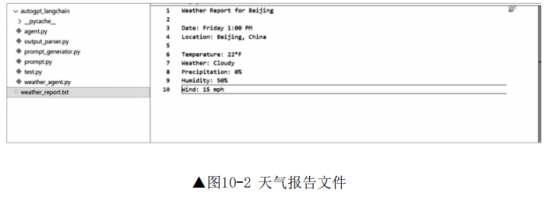

4)运行代理。单击Run按钮后,用户输入将传递给代理,代理处理输入并生成输出,如图10-1所示。在这个过程中,还会调用load_files函数来加载模型输出生成的任何文件。天气报告文件如图10-2所示。

运行结果及文件如图10-1和图10-2所示。

这个AutoGPT代理实例的实现表明,LangChain和AutoGPT的结合能够创建一个可定制的自动化AI助手来执行多种任务,如网络搜索、文件读写、语义理解等。